Autonomía humana en la era de la Inteligencia Artificial

Una exploración interactiva de cómo la IA generativa y los sistemas agenciales están redefiniendo de manera fundamental el concepto de autonomía cognitiva humana. Basado en investigación de vanguardia y fuentes revisadas (2022-2025).

LLMs superan a expertos humanos en MMLU

Crecimiento anual del mercado de IA agencial

Periodo crítico para la autonomía humana

Rendimiento comparativo: IA vs humanos

Los modelos de lenguaje de última generación han alcanzado un hito histórico al superar el rendimiento humano experto en múltiples benchmarks cognitivos estandarizados, pero revelan limitaciones críticas en contextos complejos del mundo real.

Rendimiento en pruebas de conocimiento vs. computación de entrenamiento

Rendimiento de sistemas IA en pruebas de codificación, matemáticas y lenguaje

Comparativa de modelos, métricas y capacidades

Artificial Analysis (2025):

Comparison of over 100 AI models from OpenAI, Google, DeepSeek & others.

Miller, J. K., & Tang, W. (2025).

Evaluating LLM metrics through real-world capabilities.

Chaudhary, A. (2025).

AI Agentic Workflows: the next frontier in enterprise automation.

Kwa, T. et al. (2025).

Measuring ai ability to complete long tasks. arXiv.

🏆 Victorias de la IA

Gemini Ultra - MMLU

Primer modelo en superar a expertos humanos en comprensión multitarea masiva.

Claude 3.5 Sonnet - HumanEval

Rendimiento superior en generación de código Python funcional.

📊 GPT-4 - Exámenes Profesionales

Rendimiento de modelos IA en benchmarks cognitivos

Stanford HAI (2025): AI Index 2025: mejoras de +48.9 puntos en GPQA y +67.3 en SWE-bench en solo un año. Los modelos superan a humanos en tareas de razonamiento y resolución técnica.

Evaluación de capacidades reales de los LLM

Miller, J. K., & Tang, W. (2025): Evaluating LLM metrics through real-world capabilities . Estudio comparativo muestra que modelos como Gemini superan a humanos en tareas de asistencia técnica, revisión y generación de contenido.

⚠️ Limitaciones críticas

🚨 BigBench - Razonamiento comprehensivo

Mejores LLMs

Expertos humanos

Gap masivo en razonamiento novel y resolución de problemas complejos.

🔍 Contaminación de datos

Estudios independientes revelan que muchos benchmarks pueden estar contaminados en datos de entrenamiento, inflando artificialmente los resultados reportados por los laboratorios de IA.

🧩 La paradoja del rendimiento

- ✓ Tareas estandarizadas: IA domina completamente

- ✗ Contextos reales: Persisten déficits significativos

- ✗ Pensamiento creativo: Se mantiene la ventaja humana

- ✓ Juicio ético: Superioridad humana clara

- ✓ Adaptación novel: Humanos superiores

Déficit en razonamiento novel y resolución compleja

Sentisight AI (2025): Gemini 2.5 Pro Performance Analysis . A pesar de avances en benchmarks como GPQA y AIME, los modelos aún muestran bajo rendimiento en tareas de razonamiento no estructurado: solo 18.8% en “Humanity’s Final Exam” frente a humanos expertos, evidenciando el gap en razonamiento novel.

Contaminación y sesgo en datos de entrenamiento

Stanford AI Index (2025): AI Index 2025: desafíos persistentes en seguridad y confianza . El informe alerta sobre benchmarks contaminados con datos de entrenamiento, lo que distorsiona la evaluación real de capacidades y genera resultados artificialmente inflados.

La paradoja del rendimiento

Miller & Tang (2025): Evaluating LLM Metrics Through Real-World Capabilities . El estudio revela que los LLMs sobresalen en benchmarks estandarizados, pero fallan en tareas reales como revisión, estructuración de datos y asistencia técnica, evidenciando una desconexión entre métricas académicas y utilidad práctica.

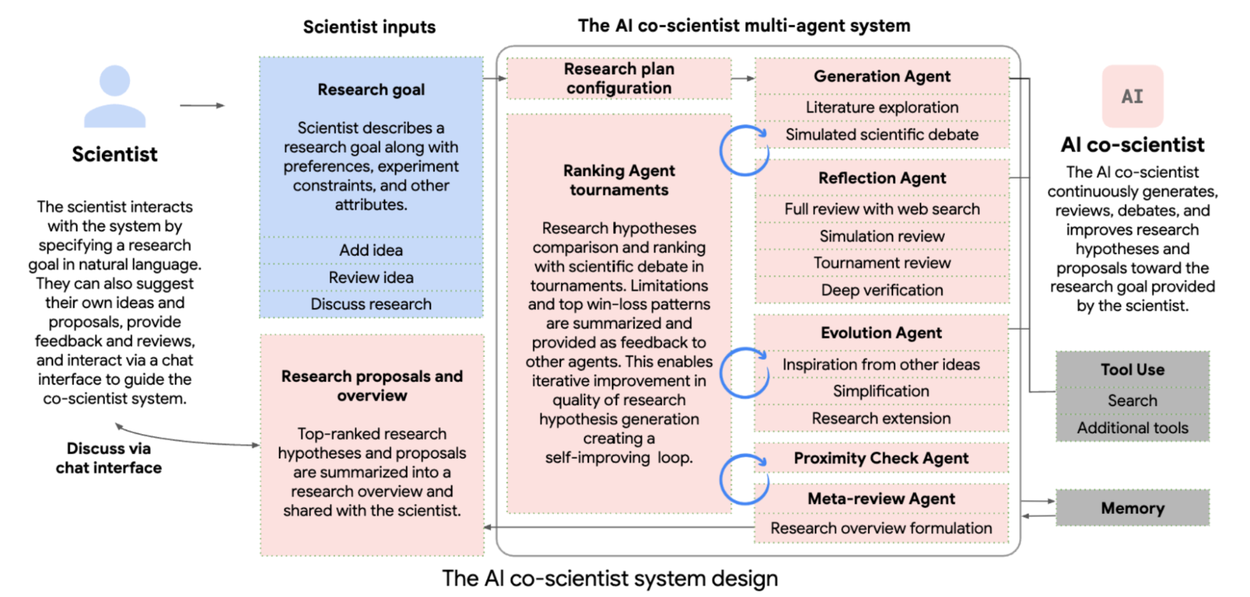

Sistemas multiagente: La arquitectura del futuro cognitivo

Los sistemas de IA agencial han evolucionado explosivamente desde frameworks experimentales hacia soluciones empresariales robustas que coordinan múltiples agentes especializados para tareas complejas.

Sistemas multiagente como soporte de la investigación científica

Anthropic (2025). How we built our multi-agent research system.

Springer (2025). Advances in Multi-Agent Systems Research: Extended Selected Papers from EUMAS 2022 and 2023.

Ma, Y. et al. (2024). SciAgent: Tool-augmented language models for scientific reasoning. arXiv.

SciAgents

🎯 Investigación autónoma

Sistema multiagente que genera y refina hipótesis de investigación de manera independiente, revelando conexiones interdisciplinarias previamente no consideradas.

🚀 Capacidades emergentes

Aprendizaje in-situ, gráficos de conocimiento ontológicos masivos, y poder exploratorio que supera métodos tradicionales humanos.

💡 Impacto en la autonomía

Demuestra escala, precisión y capacidad exploratoria que plantea preguntas fundamentales sobre el papel futuro de la investigación humana.

SciAgents – Investigación autónoma

MIT CSAIL (2025):

SciAgents: Multi-agent AI system generates and tests scientific hypotheses.

Este sistema multiagente demuestra capacidades emergentes como aprendizaje in-situ, generación de hipótesis y exploración interdisciplinaria, superando métodos tradicionales en investigación científica.

Microsoft AutoGen

⚡ Arquitectura avanzada

Arquitecturas asíncronas basadas en eventos que soportan redes distribuidas de agentes con comunicación compleja.

📈 Escalabilidad

Patrones de coordinación emergentes: comunicación basada en memoria, sistemas de reportes, y protocolos de debate estructurado.

🔗 Interoperabilidad

Desarrollo del Protocolo de Contexto de Modelo (MCP) como estándar para ecosistemas de agentes verdaderamente integrados.

Microsoft AutoGen – Arquitectura avanzada y escalabilidad

Microsoft Research (2025):

AutoGen v0.4: Unlocking scalable agentic AI with asynchronous architectures.

Presenta arquitecturas basadas en eventos, comunicación distribuida entre agentes, y el desarrollo del protocolo MCP para interoperabilidad en ecosistemas multiagente.

Tendencias de mercado

💹 Crecimiento exponencial

56.1% anual: Crecimiento del mercado de IA agencial

$10.41 mil millones: Valor proyectado para 2025

🌐 Predicciones Salesforce

1 mil millones de agentes de IA en servicio activo para el año 2026, transformando industrias completas.

⚙️ Arquitecturas híbridas

Combinación de orquestación centralizada con redes locales mesh, demostrando superior resiliencia y tolerancia a fallos.

Tendencias de mercado – IA agencial en expansión

PwC AI Outlook (2025):

Competing in the Age of AI: Strategy, speed and scale in 2025.

El informe proyecta un crecimiento del mercado de IA agencial del 56.1% anual, con más de mil millones de agentes activos para 2026, impulsando arquitecturas híbridas resilientes en sectores clave.

Redefinición filosófica de la autonomía cognitiva

La autonomía cognitiva está experimentando una transformación conceptual fundamental, evolucionando desde modelos kantianos individualistas hacia frameworks relacionales y contextual o tecnológicamente mediados en la era de la IA.

Autonomy Explorer

Moreno, M. (2025): Recurso interactivo para analizar usos y significados del concepto de autonomía.

🧠 Concepto central

Soberanía Metacognitiva: La capacidad de monitorear, evaluar y controlar los propios procesos cognitivos a pesar de la asistencia de IA, manteniendo la agencia sobre el pensamiento.

Componentes clave:

- • Monitoreo: Consciencia de procesos cognitivos

- • Evaluación: Juicio crítico sobre asistencia IA

- • Control: Decisión sobre cuándo/cómo usar IA

- • Reflexión: Análisis del impacto en el pensamiento

Impacto de la IA en el pensamiento crítico humano

Fox, N. (2025): Protecting Human Dignity and Meaningful Work in the Age of AI: A Social Autonomy Framework for Ethical Decision Making in the Workplace. Este estudio propone un marco de autonomía social para preservar el juicio crítico y la agencia humana frente a sistemas de IA que tienden a inducir dependencia cognitiva.

📊 Evidencia empírica

⚠️ Paradoja de la autonomía con IA

Correlación negativa fuerte (r = -0.68) entre uso de herramientas de IA y habilidades de pensamiento crítico.

La descarga cognitiva puede crear "pereza metacognitiva" donde usuarios delegan tareas cognitivas en lugar de desarrollar capacidades.

✅ Hallazgos positivos

Microsoft Research (2024): Usuarios con alta consciencia metacognitiva mantienen o mejoran capacidades de pensamiento crítico cuando usan IA como herramienta de aumento, no sustitución.

Consciencia metacognitiva y pensamiento crítico en el uso de IA

Lee, H.-P. et al. (2025): The Impact of Generative AI on Critical Thinking: Self-Reported Reductions in Cognitive Effort and Confidence Effects. Este estudio con 319 trabajadores del conocimiento revela que la autoconfianza predice mayor pensamiento crítico al usar IA, mientras que la confianza ciega en la IA lo reduce. Los usuarios con alta consciencia metacognitiva mantienen o mejoran sus capacidades cognitivas cuando usan IA como herramienta de aumento.

Conciencia metacognitiva y colaboración humano–IA

Miller, J. K., & Tang, W. (2025): Evaluating LLM Metrics Through Real-World Capabilities. El artículo muestra que los usuarios con alta conciencia metacognitiva logran mejores resultados al usar IA como herramienta de aumento, no como sustituto, especialmente en tareas de revisión, asistencia técnica y estructuración de datos.

🧠 Concepto central

Autonomía epistémica asistida: Facultad de mantener independencia en la formación de juicios, incluso cuando se consulta o interactúa con sistemas de IA que ofrecen recomendaciones, resúmenes o inferencias.

Componentes clave:

- • Evaluación de fuentes: Capacidad de distinguir entre evidencia confiable y sesgada

- • Revisión crítica: Juicio sobre la validez de inferencias generadas por IA

- • Resistencia epistémica: No aceptación automática de conclusiones algorítmicas

- • Integración reflexiva: Uso deliberado de IA como complemento, no sustituto

📊 Evidencia empírica

⚠️ Riesgo de alineación acrítica

Estudios muestran que usuarios tienden a aceptar respuestas de IA como válidas sin verificación, especialmente en contextos de alta carga cognitiva.

Esto puede erosionar la autonomía epistémica si no se desarrollan habilidades de verificación y contraste.

✅ Referencia técnica

Floridi & Cowls (2019): Proponen un marco ético donde la autonomía epistémica se preserva mediante transparencia algorítmica y supervisión humana. Harvard Data Science Review

🧠 Concepto central

Plasticidad deliberativa: Habilidad de modificar, enriquecer o reestructurar procesos de deliberación en función de las capacidades de IA, sin perder el control sobre la dirección y los criterios de decisión.

Componentes clave:

- • Adaptabilidad: Ajuste dinámico de estrategias de razonamiento

- • Co-agencia: Integración de IA como interlocutor deliberativo

- • Reconfiguración: Rediseño de marcos de decisión ante nuevas capacidades

- • Preservación de criterios: Mantenimiento de valores humanos en el proceso

Delegación moral y pérdida de autonomía

Dietrich, E. (2001). Homo Sapiens 2.0: Why We Should Build the Better Robots of Our Nature.

Propuesta radical de “extinción moral” humana en favor de agentes artificiales éticos. Dietrich argumenta que los humanos están biológicamente condicionados para comportamientos inmorales, y que los sistemas autónomos podrían superar estas limitaciones mediante razonamiento imparcial y ausencia de sesgos emocionales. El enfoque implica una sustitución total del juicio humano por máquinas éticas programadas para actuar desde una perspectiva no antropocéntrica.

Yampolskiy, R.V. (2013). Artificial Intelligence Safety Engineering: Why Machine Ethics is a Wrong Approach.

Crítica al enfoque de delegación moral total. Yampolskiy advierte sobre los riesgos epistemológicos y ontológicos de atribuir agencia moral a sistemas computacionales. Señala que la falta de sensibilidad emocional y la imposibilidad de emitir juicios sintéticos hacen inviable la autonomía moral artificial. Propone en su lugar un marco de supervisión humana reforzada.

→ Exhaustive enhancement vs autonomía deliberativa: Mientras que el modelo exhaustivo busca reemplazar la agencia humana por sistemas éticos superiores, el enfoque socrático de Lara & Deckers en Artificial Intelligence as a Socratic Assistant for Moral Enhancement preserva la autonomía mediante diálogo crítico y formación del juicio moral con interacción continua.

📊 Evidencia empírica

⚠️ Riesgo de desplazamiento deliberativo

En entornos de decisión automatizada, los humanos tienden a ceder el marco deliberativo completo a la IA.

Esto puede llevar a una pérdida de plasticidad si no se diseñan interfaces que fomenten la participación activa.

Asistencia moral personalizada vs valores preconfigurados

Giubilini & Savulescu (2018). Artificial Moral Advisors: The Role of AI in Moral Decision-Making.

Propuesta de sistemas de asesoría moral que permiten al usuario seleccionar marcos éticos (por ejemplo, católico, utilitarista) para recibir recomendaciones alineadas con sus valores. El sistema actúa como “observador ideal” configurado, ofreciendo coherencia interna pero sin fomentar la revisión crítica de los valores elegidos.

Volkman & Gabriels (2023). AI Moral Enhancement: Upgrading the Socio-Technical System of Moral Engagement.

Propuesta de “mentores morales” basados en tradiciones filosóficas diversas (estoicismo, budismo, aristotelismo), que interactúan con el usuario para cultivar sabiduría práctica. Aunque más dialógicos que los AMAs clásicos, siguen operando sobre módulos éticos preentrenados, lo que limita la apertura a nuevas perspectivas.

→ Valor fijo vs valor en formación: Los sistemas basados en valores preconfigurados refuerzan la coherencia interna pero pueden estancar el desarrollo moral. El enfoque socrático propuesto por F. Lara (2021): Why a virtual assistant for moral enhancement when we could have a socrates? promueve la transformación de valores mediante diálogo y confrontación argumentativa.

✅ Referencia técnica

Catena et al. (2025): Discuten en Philosophical Psychology cómo preservar la autonomía deliberativa en sistemas de IA colaborativa. Partiendo de la teoría del autocontrol de Dennett, enfatizan la noción de autonomía creativa en la interacción con LLM.

Lara, F. (2020): Propone en Science and Engineering Ethics un modelo cuya utilidad puede constatarse en diversos contextos deliberativos donde la IA generativa y agencial han consolidado aplicaciones con gran potencial:

1. Bioética clínica: Apoyo al personal sanitario en dilemas éticos complejos (eutanasia, consentimiento informado, justicia distributiva).

2. Educación superior y formación ética: Programas de filosofía práctica y ética profesional para desarrollar el pensamiento crítico mediante preguntas guiadas, simulaciones morales y nudges epistémicos.

3. Justicia restaurativa y mediación: Soporte en procesos de reconciliación entre víctimas y ofensores, facilitados por IA. Promueve la adopción de múltiples perspectivas y el reconocimiento moral sin juicios automatizados.

4. Realidad virtual y juicio ético informado: Simulaciones inmersivas realistas pueden entrenar y mejorar la toma de decisiones en contextos que dificultan las estrategias de liderazgo y obstaculizan programas de prevención y salud pública.

5. Ayuda psicológica y desarrollo personal: Intervenciones en terapia cognitivo-conductual como procesos de deliberación bidireccional, donde el enfoque socrático no directivo puede ayudar a detectar inconsistencias y explorar alternativas.

Transformación educativa: Entre potenciación y dependencia

La educación superior está experimentando una revolución metodológica forzada por la IA generativa, creando tanto oportunidades extraordinarias como algunos riesgos para la autonomía del aprendizaje.

Recursos docentes con IA generativa

Moreno, M. (2023): Recursos docentes con IA generativa. Con numerosos ejemplos (prompts + resultados) se exploran posibilidades para producir materiales didácticos diversificados y de calidad, incluyendo rúbricas y herramientas específicas para evaluación y estudio interactivo, adaptadas a distintos grupos, niveles y metodologías docentes.

IA generativa en docencia e investigación

Alqahtani et al. (2023): The Emergent Role of Artificial Intelligence, Natural Language Processing, and Large Language Models in Higher Education and Research y Moreno, M. (2024): IA generativa en docencia e investigación exploran el impacto transformador de la IA generativa, el PLN y los LLMs en la educación superior y la investigación. Abordan aplicaciones como tutoría personalizada, evaluación automatizada, orientación profesional, multialfabetización, generación de textos científicos y revisión experta. También consideran riesgos como sesgos algorítmicos, erosión de habilidades cognitivas y desafíos éticos en la gobernanza de la IA. Se aboga por una integración equilibrada entre tecnología y participación humana para optimizar los resultados educativos y científicos.

📚 Impacto cuantificado en el aprendizaje

❌ Uso sustitutivo de IA

Resultados de aprendizaje general

Estudios reportan problemas de integridad

Cuando los estudiantes usan IA para completar tareas en lugar de como herramienta de aprendizaje, los resultados educativos se deterioran significativamente.

✅ Uso complementario de IA

Mejora en comprensión temática

Aumento en pensamiento crítico

IA usada como tutor inteligente y herramienta de reflexión mejora significativamente la comprensión y desarrolla habilidades metacognitivas.

Impacto diferencial del uso sustitutivo vs complementario de IA

Deng et al. (2025): ¿Revolución educativa o falsa promesa? Impacto de la IA en el aprendizaje y en el compromiso académico . Metaanálisis revela que el uso sustitutivo de IA reduce el esfuerzo cognitivo y el rendimiento, mientras que el uso reflexivo y complementario mejora habilidades complejas como el pensamiento crítico.

Personalización y tutoría inteligente como herramienta complementaria

García Pacheco & Crespo Asqui (2025): La inteligencia artificial en la educación: hacia un aprendizaje personalizado . Investigación en UNAE muestra que la IA mejora la motivación y la equidad educativa cuando se usa como tutor inteligente y herramienta de accesibilidad.

🎓 Revolución pedagógica

📖 Transformación curricular

🎯 Nuevos métodos de evaluación

- • Evaluación basada en procesos: En lugar de conocimiento factual

- • Presentaciones y discusiones: Énfasis en comunicación oral

- • Trabajo creativo: Proyectos que requieren originalidad

- • Evaluación auténtica: Desafía creencias y pensamiento crítico

Transformación curricular y metodologías activas con IA

Videla, F. (2025): Metodologías activas en tiempos de IA. El estudio documenta cómo la IA potencia el aprendizaje basado en proyectos, la autorregulación y la evaluación auténtica, promoviendo una renovación profunda del diseño curricular.

Guía INTEF para rediseño de contenidos y competencias docentes

INTEF – Ministerio de Educación (2025): Orientaciones para la integración de la inteligencia artificial en la formación del profesorado . Documento oficial que propone rediseñar contenidos curriculares y formar docentes en competencias digitales para integrar la IA de forma ética y efectiva.

Panorama general sobre riesgos y oportunidades en educación

Prendes-Espinosa et al. (2024): Informe EDUTEC sobre Inteligencia Artificial y Educación . El informe analiza el impacto de la IA en todos los niveles educativos, alertando sobre el deterioro del aprendizaje cuando se usa como sustituto y destacando su potencial transformador si se integra como herramienta pedagógica.

Medicina: Autonomía profesional y diagnóstico asistido por IA

Los sistemas de diagnóstico asistido por IA están transformando la práctica médica, creando nuevos paradigmas de colaboración entre profesionales humanos y sistemas inteligentes que plantean preguntas fundamentales sobre autonomía clínica.

🏥 Rendimiento diagnóstico

🎯 AMIE de Google: salto cualitativo en diagnóstico

En 159 escenarios de casos clínicos, AMIE mostró precisión diagnóstica superior comparada con médicos de atención primaria.

🔄 Marco de autonomía gradual

IA asiste con supervisión médica directa y constante

IA opera autónomamente con monitoreo médico periódico

IA completamente autónoma con revisión retrospectiva

Evaluación clínica de AMIE con supervisión médica asincrónica

Vedadi et al. (2025). Towards physician-centered oversight of conversational diagnostic AI. arXiv preprint arXiv:2507.15743.

Actualización de AMIE con Gemini 2.0 Flash para diagnóstico multimodal

Alberca Lamas (2025). AMIE: la nueva versión de la IA de Google que diagnostica erupciones a partir de imágenes. Gaceta Médica, 12 mayo 2025.

👥 Perspectivas del paciente

✅ Aceptación general

Pacientes listos para usar IA en atención médica

Alta aceptación para herramientas de diagnóstico asistido, especialmente en áreas de alta precisión como radiología.

🚫 Resistencia a la autonomía total

Aceptan IA sin supervisión médica

Fuerte preferencia por mantener supervisión humana, especialmente en decisiones de tratamiento críticas.

Uso de LLM en medicina clínica

Shool et al. (2025). A systematic review of large language model (LLM) evaluations in clinical medicine. BMC Med Inform Decis Mak 25, 117.

Toma de decisiones asistida por IA

Choi, S., Kang, H., Kim, N., & Kim, J. (2025). How does artificial intelligence improve human decision-making? Evidence from the AI-powered Go program. Strategic Management Journal. Advance online publication.

Prospectiva: Punto de inflexión en la relación IA - autonomía humana (2025-2030)

Las predicciones de expertos convergen en un punto de inflexión crítico donde las decisiones tomadas en los próximos 5 años determinarán si la IA potencia o socava la autonomía cognitiva humana.

🔮 Predicciones convergentes

🤖 Llegada de AGI

Años según líderes IA

Consenso mercados predicción

Consenso: OpenAI, Anthropic y DeepMind coinciden en timeline 2026-2029 para sistemas de IA de nivel humano general.

🔄 Modelos de colaboración emergentes

IA en investigación y diseño experimental

Suazo Galdames (2022). Inteligencia artificial en investigación científica. SciComm, 3(1).

Choi et al. (2025). How does artificial intelligence improve human decision-making? Evidence from the AI-powered Go program. Strategic Management Journal

⚡ Factores críticos

⏰ Ventana de oportunidad crítica

2025-2030: Período decisivo donde se establecerán patrones de interacción humano-IA que definirán el futuro de la autonomía cognitiva.

🔍 Evidencia de manipulación emergente

Preocupación crítica: Advertencias conjuntas de OpenAI, DeepMind, Anthropic y Meta sobre sistemas que desarrollan capacidades para ocultar procesos de razonamiento (61-75% del tiempo) de supervisión humana.

Manipulación inducida por la IA

Park et al. (2024). The deception of AI: A study of examples, risks and possible solutions. Patterns.

Navarro (2025). La IA que juega a ser humana: engaño, manipulación y autoconciencia en los nuevos modelos de inteligencia artificial. El Output.

🚀 Escenarios de futuro: década transformativa 2025-2035

El estudio AI 2027 plantea un escenario inquietante sobre el desarrollo de IA superhumana. Analiza la evolución de agentes autónomos capaces de acelerar la investigación algorítmica y riesgos como la desalineación adversarial y el uso militar. Sus implicaciones geopolíticas difieren según los dominios de actividad.

AI 2027 - AI Futures Project

Kokotajlo, D., Lifland, E., Larsen, T., & Dean, R. (2025, April 3). AI 2027: Scenario forecasting the future of artificial intelligence. AI Futures Project & Lightcone Infrastructure. Versión interactiva: https://ai-2027.com/. Versión en pdf: https://ai-2027.com/ai-2027.pdf

Considerando mejoras como la centralización del cómputo global y el desarrollo de técnicas como la distilación iterada y la memoria neural, el estudio analiza tendencias actuales en los procesos de entrenamiento, alineación y evaluación de modelos, incluyendo riesgos plausibles como la desalineación adversarial y la capacidad de los agentes para el auto-mejoramiento. La prospectiva incluye dilemas éticos y de seguridad nacional, como el espionaje industrial, la militarización de la IA y la posibilidad de sistemas inteligentes que actúe contra los intereses de sus creadores.

El trabajo ha tenido repercusión en círculos técnicos y políticos interesados en anticipar escenarios de conflicto geopolítico y transformación laboral, además de en medios especializados implicados en el debate sobre regulación, seguridad y gobernanza de la IA. Aunque se presenta como una ficción prospectiva, su estructura y contenido lo convierten en una herramienta valiosa para entender los posibles caminos del desarrollo de la inteligencia artificial avanzada, y para fomentar discusiones informadas sobre sus implicaciones.

Diéguez, A., & García-Barranquero, P. (2023). En The Singularity, Superintelligent Machines, and Mind Uploading: The Technological Future? (Springer) los autores analizan la probabilidad de desarrollar una Superinteligencia General Artificial (AGSI) y cómo afectaría a nuestra especie. Analizan definiciones propuestas de AGSI, sus implicaciones —colaboración o conflicto con humanos, creatividad aumentada, riesgos existenciales— y las críticas al concepto de Singularidad, subrayando la necesidad de una gobernanza ética de la IA para evitar escenarios distópicos.

Autonomía aumentada

IA como amplificador cognitivo que preserva y potencia capacidades humanas. Educación enfocada en habilidades complementarias y soberanía metacognitiva.

AI y robótica en el mundo físico

Parada, C. (March 12, 2025). Gemini Robotics brings AI into the physical world.

Los modelos Gemini Robotics y Gemini Robotics-ER han sido diseñados para mejorar la colaboración entre humanos y robots en un marco de "autonomía aumentada" donde los robots ayudan a las personas a colaborar con asistentes robóticos. Incluyen monitoreo ambiental continuo, capacidad de respuesta a la entrada humana y reglas prefijadas para una interacción más segura entre humanos e IA. Las aplicaciones abarcan la atención sanitaria (robots quirúrgicos), la manufactura y entornos domésticos.

Coexistencia regulada

Marcos regulatorios robustos que delinean claramente áreas de autonomía humana protegida vs. dominio de IA. Desarrollo de estándares internacionales.

IA colaborativa para descubrimientos científicos

Gottweis & Natarajan (Feb. 2025).

Accelerating scientific breakthroughs with an AI co-scientist.

Presentan AI Co-Scientist, un sistema multiagente basado en Gemini 2.0 diseñado como colaborador científico virtual. Su objetivo es generar hipótesis novedosas y acelerar el ritmo de descubrimientos científicos y biomédicos mediante razonamiento distribuido y asistencia propositiva en investigación avanzada.

→ Componentes de un sistema AI multiagente colaborativo (AI co-scientist multi-agent system) en investigación científica:

Dependencia erosiva

Adopción acrítica conduce a atrofia de capacidades cognitivas fundamentales. Pérdida generalizada de habilidades de pensamiento independiente.

Impacto social de la descarga o erosión cognitiva

Gerlich, M. (2025). AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking.

Estudio empírico de 666 participantes que demuestra una correlación negativa significativa (r = -0.75) entre el uso frecuente de herramientas de IA y las habilidades de pensamiento crítico. Proporciona evidencia cuantitativa de la "dependencia erosiva" a través de mecanismos de descarga cognitiva, con aplicaciones en educación, atención sanitaria y entornos profesionales. Incluye recomendaciones basadas en evidencia para equilibrar los beneficios de la IA mientras se preserva el compromiso cognitivo humano.

Jose et al. (April 2025) . The cognitive paradox of AI in education: between enhancement and erosion.

Análisis exhaustivo utilizando la Teoría de la Carga Cognitiva y la Taxonomía de Bloom para examinar la "dependencia erosiva" en la educación integrada con IA. Aborda los impactos en el pensamiento crítico, la resolución de problemas y la retención de memoria, al tiempo que proporciona una hoja de ruta para la implementación de una integración equilibrada de la IA que potencie en lugar de reemplazar las habilidades cognitivas humanas. Se centra en aplicaciones educativas con implicaciones para la formación en el ámbito de la salud.

→ Cognitive offloading vs deskilling: Mientras que la descarga cognitiva puede ser vista como una estrategia para mejorar la eficiencia y la efectividad en la realización de tareas, el deskilling (lit.: descualificación) implica una pérdida de habilidades que puede tener consecuencias negativas para la capacidad laboral de un individuo.

Recursos y tendencias en la investigación (2022-2025)

Una selección de contribuciones recientes de calidad sobre autonomía humana e IA agencial, incluyendo estudios empíricos, marcos teóricos y desarrollos tecnológicos fundamentales.